기존에 하둡설치에서 master01 , slave01 을 구축했었습니다. 저는 이 두개의 서버에 카프카를 구축 합니다.

wget http://apache.mirror.cdnetworks.com/kafka/2.5.0/kafka_2.12-2.5.0.tgz

두 서버에 카프카를 먼저 설치합니다.

* 참고!! 2888, 3888, 2181 포트를 모두 개방해주세요

vi config/zookeeper.properties (master01,slave01)

설정합니다.

그 다음

vi config/server.properties

master01 에서는

만 찾아서 설정해주시고

slave01은 id값만 2로 변경!!

이후에 위에 dataDir을 설정한 경로에 파일을 만들고

master01 -

echo 1 > /opt/kafka/current/tmp/zookeeper/myid

slave01 -

echo 2 > /opt/kafka/current/tmp/zookeeper/myid

bin/zookeeper-server-start.sh config/zookeeper.properties

bin/kafka-server-start.sh config/server.properties

*참고!!! master01과 slave01에서 다 실행해야 됩니다

토픽 생성

$ bin/kafka-topics.sh --create --zookeeper master01:2181,slave01:2181 --replication-factor 2 --partitions 1 --topic hana01

Created topic hana01.

토픽 리스트 확인

$ bin/kafka-topics.sh --list --zookeeper master01:2181,slave01:2181

출력 hana01

producer 메세지 생산하기

[root@was01 kafka]# bin/kafka-console-producer.sh --broker-list master01:9092,slave01:9092 --topic hana01

>hello kafka~~~

>data11111111111

>date22222222222

[root@was02 kafka]# bin/kafka-console-consumer.sh --bootstrap-server master01:9092,slave01:9092--topic hana01 --from-beginning

hello kafka~~~

data11111111111

date22222222222

카프카 구축 끝~

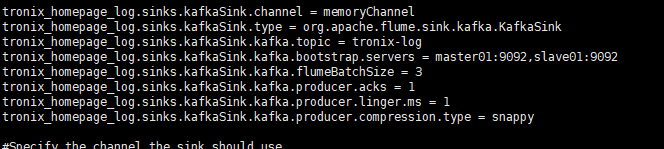

flume에 적용 시키는것

요룡됴

'빅데이터 > Hadoop' 카테고리의 다른 글

| 스파크 카프카 실시간 연동 구축 (0) | 2020.07.01 |

|---|---|

| SPARK 설치 후 zepplien까지 ~ (0) | 2020.06.25 |

| CentOs7 - Python 3.6.8 설치 (12) | 2020.06.23 |

| CentOs7 방화벽 설정 부분 정리 (0) | 2020.06.22 |

| Hadoop 설치 및 실행 (0) | 2020.06.22 |

댓글